Eine Beobachtung aus der Praxis

Eine einzelne Rückmeldung verweist auf ein strukturelles Muster im Markt für KI‑Weiterbildung.

„Erschöpfung. Schlafstörungen. Ich kann das allein nicht umsetzen.“

Diese Rückmeldung erhielt ich von einem Unternehmer nach mehreren Investitionen in KI‑Weiterbildungen. Er hatte Kurse besucht, an Webinaren teilgenommen und war Teil einer Community. Das Versprechen war Orientierung. Das Ergebnis war Überforderung.

Diese Erfahrung steht nicht für einen Einzelfall. Sie verweist auf ein Muster, das sich im Markt für KI‑Weiterbildung zunehmend zeigt.

Ein Markt im Beschleunigungsmodus

Künstliche Intelligenz verändert Bildungsangebote rasant. In kurzer Zeit sind unzählige KI‑Kurse, Bootcamps, Akademien und Communities entstanden. Sie versprechen Kompetenz, Sicherheit und Anschlussfähigkeit, mit oder ohne anerkannte Abschlüsse.

Gleichzeitig höre ich in Gesprächen immer wieder denselben Satz:

„Ich lerne viel, aber es wird nicht klarer.“

Der Markt wächst schneller als die Fähigkeit vieler Lernender, Inhalte einzuordnen. Neue Tools, neue Anforderungen und neue rechtliche Rahmenbedingungen erscheinen in hoher Frequenz. Klarheit entfernt sich.

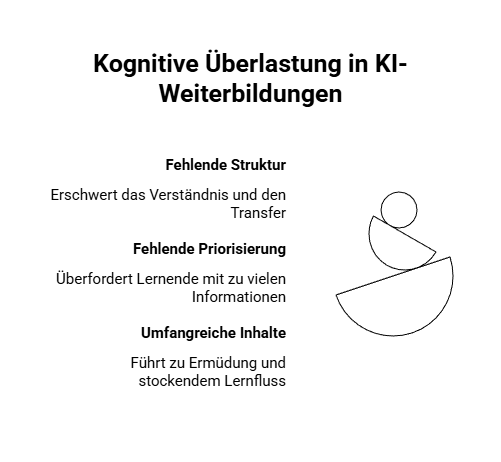

Überforderung statt Lernfluss

Diese Beobachtungen sind kein individuelles Empfinden. Studien aus der Bildungsforschung beschreiben seit Jahren, dass Lernangebote ohne klare Struktur und Priorisierung zu kognitiver Überlastung führen. John Sweller entwickelte Theorie der kognitiven Belastung zeigen, dass umfangreiche, schlecht gegliederte Lerninhalte nicht zu mehr Kompetenz führen, sondern Verständnis und Transferfähigkeit mindern.

Viele Angebote sind umfangreich angelegt. Module folgen aufeinander, ergänzt durch Updates, Challenges und Zusatzmaterialien. Für manche Lernende mag das funktionieren, wenn sie in diesem Thema Vorwissen mitbringen. Für viele andere verhindert der Umfang jedoch einen tragfähigen Lernfluss.

Lernen im Alleingang gerät ins Stocken. Verbindlichkeit und Struktur fehlen. Was als Weiterbildung gedacht ist, wird zur Dauerbeschäftigung.

Die Folge ist Ermüdung, weil Lernen ohne Einordnung anstrengend ist.

Informationsasymmetrie als strukturelles Problem

Ein zentraler Faktor ist Informationsasymmetrie. Viele Lernende können nicht einschätzen, welches Vorwissen erforderlich ist, welche Inhalte tatsächlich relevant sind und welche Risiken mit dem Einsatz von KI verbunden sind. Diese Asymmetrie wird nicht immer ausgeglichen. Erkennbar ist das an der Marketingsprache in den beworbenen KI‑Lernangeboten, die Sicherheit betont und mit Dringlichkeit arbeitet. Orientierung wird versprochen, ohne Voraussetzungen klar zu benennen.

Technische Komplexität und Verantwortung

In manchen Kursen werden Einzelunternehmer ohne technisches Vorwissen ermutigt, KI‑Workflows abzubilden. Häufig fehlt dabei die Einordnung: wo die Grenzen der eingesetzten Modelle liegen, welche Blackbox‑Risiken bestehen und wer im Unternehmen haftet.

Oft bleibt unerwähnt, dass die Verantwortung für den KI‑Einsatz beim Unternehmer selbst liegt, nicht beim Kursanbieter oder externen Experten.

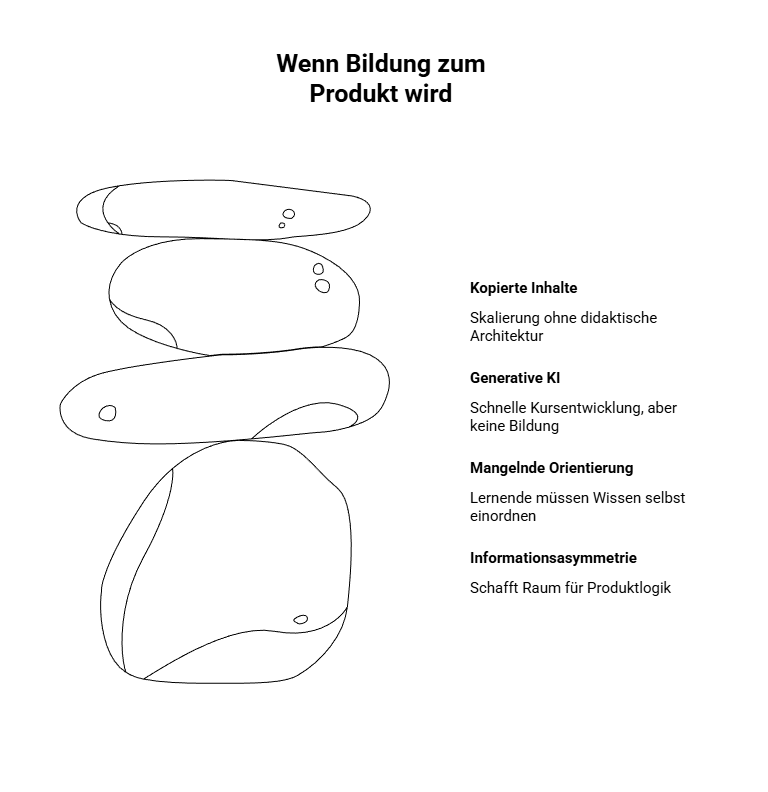

Bildung als Produkt

Wo Informationsasymmetrie besteht und Orientierung fehlt, entsteht Raum für Produktlogik.

Mit generativer KI lassen sich Kurse heute schnell erstellen. Inhalte werden zusammengetragen, strukturiert und veröffentlicht. Was früher didaktische Erfahrung und Zeit erforderte, entsteht heute mit der neuen Technologie in kurzer Zeit.

Der Einsatz von KI zur Unterstützung bei der Kurskonzeption ist legitim. Problematisch wird es dort, wo Inhalte lediglich kopiert, skaliert und nach immer gleichen Vorlagen produziert werden. In solchen Fällen entsteht zwar ein Produkt, aber keine Bildung.

Ohne didaktische Architektur bleibt Wissen fragmentiert. Lernende tragen die Verantwortung für die Einordnung und Umsetzung allein.

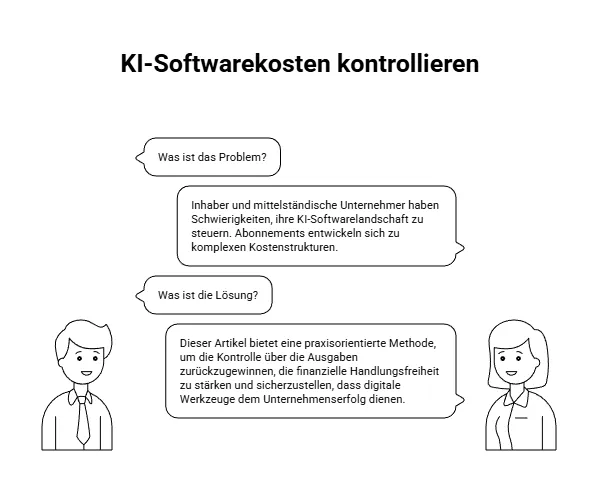

Geschäftsmodelle der Bindung

Viele Angebote folgen einem Bündel- und Abo‑Modell. Einzelne Kurse sind in Akademien nicht wählbar. Zugänge sind zeitlich begrenzt. Lernende erwerben ein Sammelsurium aus Webinaren, Aufzeichnungen und Updates.

Und dort, wo Jahresabos notwendig sind, um Zugang zu Expertise zu erhalten, stellt sich die Frage: Geht es um Bildung oder um Bindung?

Wenn Vertreter von Branchen mit besonderem Berufsethos Teil solcher Modelle werden, stellt sich zusätzlich die Frage nach Unabhängigkeit und möglichen Interessenkonflikten.

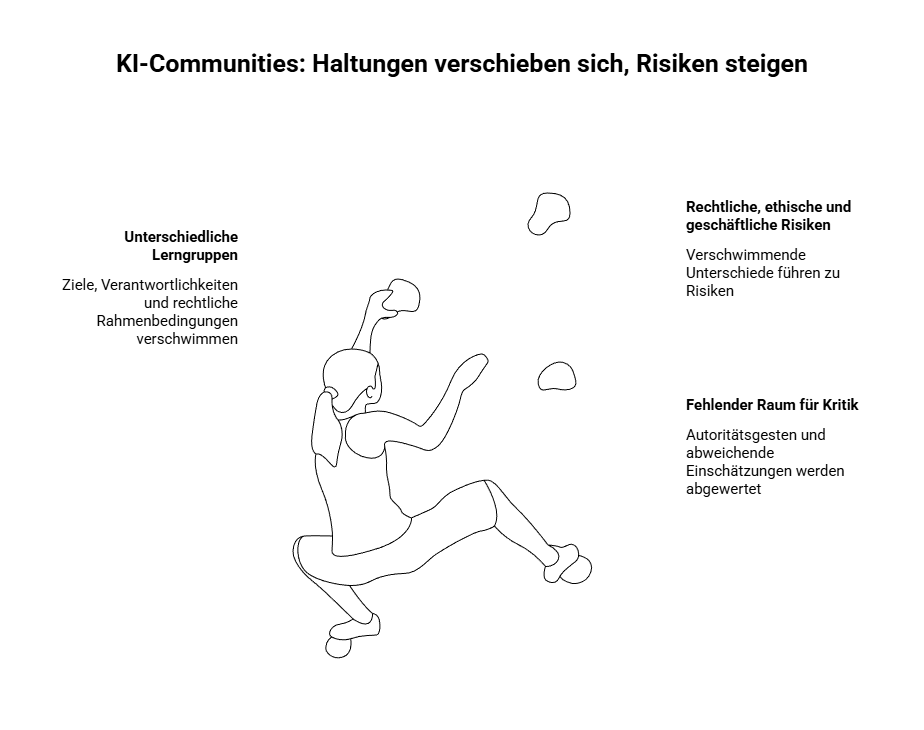

Soziale Dynamiken in Communities

Ein weiteres Muster zeigt sich in Communities. Haltungen verschieben sich teils rasch: Neugier weicht Gewissheit, zugespitzte Szenarien werden übernommen. Aussagen wie „AGI ist längst da“ kursieren, ohne dass sie eingeordnet oder kritisch geprüft werden. In einzelnen Fällen geht dies mit einer demonstrativen Selbstinszenierung einher – sichtbar in Bildsprache oder Wortwahl.

Kritische Wortmeldungen finden dabei nicht immer Raum. Statt inhaltlicher Auseinandersetzung treten bisweilen Autoritätsgesten auf; abweichende Einschätzungen werden mit dem Hinweis ausgehebelt, man wisse es besser.

Hinzu kommt ein strukturelles Spannungsfeld: In vielen Communities treffen sehr unterschiedliche Lerngruppen aufeinander – pensionierte Privatpersonen, neugierig Interessierte, Angestellte, Einzelunternehmer sowie Führungskräfte aus Unternehmen. Diese Gruppen verfolgen unterschiedliche Ziele und unterliegen unterschiedlichen Verantwortlichkeiten und rechtlichen Rahmenbedingungen.

Was für die eine Gruppe ein unverbindliches Experiment ist, kann für eine andere haftungsrelevant sein. Während einige lernen, um zu verstehen, setzen andere KI produktiv in Kunden- oder Unternehmenskontexten ein. In gemischten Lerngruppen verschwimmen diese Unterschiede häufig. Rechtliche, organisatorische und ethische Anforderungen werden nivelliert, obwohl sie zentral wären.

In diesem Umfeld zeigen sich weitere Muster: Manche Inhaber setzen KI ein, ohne dies transparent zu machen. Andere relativieren Verantwortung mit dem Hinweis: „Machen ja alle.“ Wieder andere sprechen von „eigener KI“, meinen jedoch webbasierte Chatmodelle und laden sensible oder personenbezogene Dokumente hoch.

Wo technisches Verständnis fehlt, Rollen und Verantwortlichkeiten nicht sauber getrennt werden und Gruppendynamik Reflexion ersetzt, entstehen Risiken – rechtlich, ethisch und geschäftlich.

Die Folgen für Lernende

Viele berichten von fehlender Klarheit. Fragen bleiben unbeantwortet. Die Kosten für Tools und Abos geraten aus dem Blick. Manche geben auf oder nutzen KI nur noch intern.

Das Gefühl, nicht kompetent genug zu sein, entsteht, weil die Einordnung und die Struktur fehlen.

Alternativen existieren

Anerkannte Hochschulen bieten kostenfreie Kurse zu KI und zum EU AI Act an. Auch Technologieanbieter wie OpenAI stellen über eigene Lernplattformen strukturierte, frei zugängliche Schulungsangebote bereit, die Grundlagen, Anwendungslogik und verantwortungsvollen Einsatz vermitteln. Auch seriöse private Anbieter existieren. Sie legen Wert auf fachliche Tiefe und verzichten auf überrissene Versprechen. Ihre Qualität erschliesst sich weniger über Marketing als durch Erfahrung, Einordnung und kontinuierliche Auseinandersetzung mit der Materie.

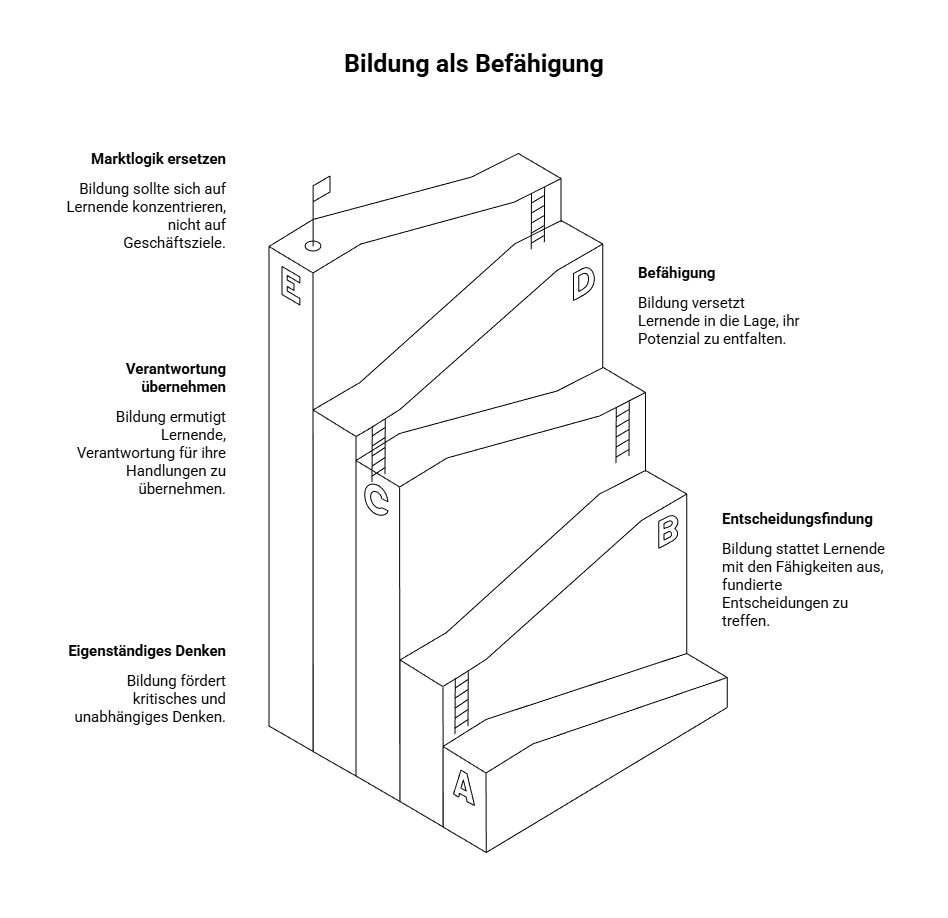

Der Auftrag von Bildung

Der Auftrag von Bildung ist Befähigung. Sie versetzt Menschen in die Lage, eigenständig zu denken, zu entscheiden und Verantwortung zu übernehmen.

Wo Bildung primär als Produkt für Geschäftsziele organisiert wird, kehrt sich dieser Auftrag um. Lernende zahlen, liefern Aufmerksamkeit und bleiben von Modellen abhängig, die sie selbst finanzieren.

Bildung verliert dort ihren Zweck, wo Marktlogik Bildungslogik ersetzt.

Dass diese Entwicklung kein subjektiver Eindruck ist, sondern strukturelle Ursachen hat, belegen internationale Studien und Berichte der letzten Jahre.

Einordnung durch Studien und Berichte

Die hier beschriebenen Beobachtungen werden durch verschiedene Studien und Berichte aus den Jahren 2025 und 2026 gestützt. Sie weisen übereinstimmend darauf hin, dass die zunehmende Kommerzialisierung von KI‑Weiterbildung kritisch zu hinterfragen ist – insbesondere dort, wo Lernen als kurzfristiges Konsumprodukt vermarktet wird.

Die UNESCO warnt in ihrem Bericht AI and Education: Protecting the Rights of Learners (2025) ausdrücklich vor einer technologiezentrierten Bildung.

Bildung dürfe nicht zu einem Markt für Technologieanbieter werden. Wo Digitalisierung ohne robuste pädagogische Rahmenbedingungen vorangetrieben wird, droht eine Entwertung des Bildungsbegriffs. Ein rein produktorientierter Ansatz vernachlässigt sowohl die kognitive Entwicklung als auch die Interaktion zwischen Lehrenden und Lernenden.

Auch Analysen zu kommerziellen KI‑Kursen benennen wiederkehrende Risikomuster. Dazu zählen unrealistische Versprechen, ein starker Fokus auf kurzfristige Tool‑Anwendung statt auf grundlegende KI‑Literacy sowie eine wachsende Abhängigkeit von vorgefertigten Systemen. Studien sprechen in diesem Zusammenhang von einer möglichen Erosion von Fähigkeiten, wenn Lernen auf Bedienung reduziert wird und kritisches Hinterfragen ausbleibt.

Hinzu kommt ein strukturelles Marktproblem: In Bildungs‑ und Plattformmärkten besteht eine ausgeprägte Informationsasymmetrie. Die Qualität eines Angebots lässt sich häufig erst nach Abschluss beurteilen.

Dadurch setzen sich nicht zwangsläufig Anbieter mit der besten pädagogischen Konzeption durch, sondern jene mit der höchsten Sichtbarkeit.

Studien zeigen zudem, dass ein erheblicher Teil von KI‑Projekten in Unternehmen scheitert, weil Schulungen technische Werkzeuge isoliert betrachten und zentrale Voraussetzungen wie Datenqualität, Organisationskultur und Verantwortung ausblenden.

Aus diesen Befunden leiten internationale Organisationen wie die UNESCO Empfehlungen ab, die KI‑Weiterbildung als Befähigungsprozess zu gestalten.

Die EU verweist im Rahmen des Digital Education Action Plans darauf, dass digitale Bildung nicht allein technisches Know-how vermitteln darf, sondern auch Medienkompetenz, Urteilsfähigkeit und Resilienz gegenüber Desinformation fördern muss.

Wo Bildung auf Produktlogik und Toolbedienung reduziert wird, bleiben genau diese Fähigkeiten unterentwickelt.

Dazu gehören ein menschenzentrierter Ansatz, die Förderung des Urteilsvermögens und der ethischen Entscheidungsfähigkeit sowie klare regulatorische Leitplanken. Der EU AI Act, der ab 2026 schrittweise wirksam wird, setzt hier erstmals verbindliche Anforderungen für den Einsatz von KI auch im Bildungsbereich.

Diese Studien liefern keine Gegenargumente zur Praxis vieler KI‑Anbieter. Sie erklären vielmehr, warum die beschriebenen Effekte auftreten und warum Bildung ohne Struktur, Einordnung und Verantwortung langfristig scheitert.

Sie erklären nicht nur, warum Überforderung entsteht. Sie zeigen auch, warum Bildung ohne Struktur, Einordnung und Verantwortung ihren Zweck verfehlt.

Manuela Frenzel ist unabhängige Publizistin für Technologie und Gesellschaft.

Hinweis zur Transparenz: Hinweis zur Transparenz: Die Vertonung erfolgte KI-gestützt.